Актуальное Зеркало 1xbet: Быстрый Доступ к Вашим Ставкам

Вы когда-нибудь сталкивались с проблемой доступа к любимому сайту для ставок? В современном мире, где интернет-цензура становится всё более жесткой, найти рабочее зеркало 1xbet может оказаться настоящим вызовом. Но что же такое «зеркало» и как оно может помочь вам обойти блокировки? В этом посте мы разберем, что такое зеркало 1xbet, как его использовать и какие преимущества оно может предоставить.

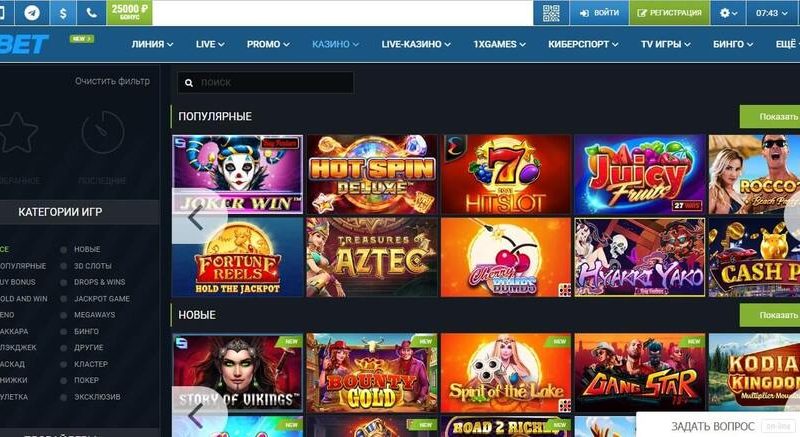

Зеркало сайта — это альтернативный домен, который позволяет пользователям обходить блокировки и получать доступ к заблокированному ресурсу. В случае с 1xbet, зеркала помогают игрокам продолжать делать ставки и пользоваться всеми функциями сайта, несмотря на ограничения.

В этом посте мы рассмотрим:

1. Что такое зеркало 1xbet и как оно работает.

2. Как найти рабочее зеркало 1xbet.

3. Преимущества использования зеркала для доступа к сайту.

Присоединяйтесь к нам, чтобы узнать, как легко и безопасно обойти блокировки и продолжать наслаждаться любимыми ставками на 1xbet!

Введение

Современные технологии активно развиваются, и искусственный интеллект (ИИ) занимает важное место в этой эволюции. Одним из самых продвинутых ИИ является GPT (Generative Pre-trained Transformer). В этой статье мы рассмотрим, как эффективно загрузить и использовать GPT, чтобы получить максимальную пользу от его возможностей.

Установка и настройка GPT

Для начала работы с GPT необходимо установить соответствующие библиотеки и настроить окружение. Рассмотрим основные шаги для этого процесса.

Установка необходимых библиотек

pip install transformers

pip install torchНастройка окружения

Создайте виртуальное окружение для изоляции зависимостей проекта:

python -m venv gpt-env

source gpt-env/bin/activate # для Linux/MacOS

gpt-env\Scripts\activate # для WindowsЗагрузка модели GPT

После настройки окружения необходимо загрузить модель GPT. Рассмотрим, как это сделать с использованием библиотеки transformers от Hugging Face.

Пример кода для загрузки модели

from transformers import GPT2LMHeadModel, GPT2Tokenizer

# Загрузка токенизатора и модели

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2")Генерация текста с помощью GPT

Теперь, когда модель загружена, можно приступить к генерации текста. Рассмотрим основные шаги и примеры кода для этого процесса.

Подготовка входных данных

Для начала необходимо подготовить входные данные, которые будут использоваться для генерации текста.

input_text = "Сегодня погода"

input_ids = tokenizer.encode(input_text, return_tensors="pt")Генерация текста

С помощью метода generate можно получить сгенерированный текст на основе входных данных.

output = model.generate(input_ids, max_length=50, num_return_sequences=1)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)Оптимизация производительности

Для улучшения производительности и эффективности работы с GPT можно использовать различные методы оптимизации.

Использование GPU

Для ускорения вычислений рекомендуется использовать GPU. Убедитесь, что у вас установлены необходимые драйверы и библиотека torch поддерживает CUDA.

import torch

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

input_ids = input_ids.to(device)Пакетная обработка

Для увеличения производительности можно использовать пакетную обработку данных.

batch_size = 8

input_texts = ["Текст 1", "Текст 2", "Текст 3", "Текст 4", "Текст 5", "Текст 6", "Текст 7", "Текст 8"]

input_ids = [tokenizer.encode(text, return_tensors="pt") for text in input_texts]

input_ids = torch.cat(input_ids, dim=0).to(device)

output = model.generate(input_ids, max_length=50, num_return_sequences=1)

generated_texts = [tokenizer.decode(out, skip_special_tokens=True) for out in output]

for text in generated_texts:

print(text)Пользовательские настройки и расширения

Для более гибкой работы с GPT можно использовать различные настройки и расширения модели.

Настройка параметров генерации

Параметры генерации, такие как max_length, num_return_sequences, temperature и top_p, позволяют контролировать процесс генерации текста.

output = model.generate(input_ids, max_length=100, num_return_sequences=3, temperature=0.7, top_p=0.9)

generated_texts = [tokenizer.decode(out, skip_special_tokens=True) for out in output]

for text in generated_texts:

print(text)Финетюнинг модели

Для адаптации GPT под конкретные задачи можно провести финетюнинг модели на специализированных данных.

Пример кода для финетюнинга

from transformers import TextDataset, DataCollatorForLanguageModeling, Trainer, TrainingArguments

# Подготовка данных для финетюнинга

train_dataset = TextDataset(

tokenizer=tokenizer,

file_path="path/to/train.txt",

block_size=128,

)

data_collator = DataCollatorForLanguageModeling(

tokenizer=tokenizer,

mlm=False,

)

# Настройка параметров тренировки

training_args = TrainingArguments(

output_dir="./results",

overwrite_output_dir=True,

num_train_epochs=1,

per_device_train_batch_size=4,

save_steps=10_000,

save_total_limit=2,

)

# Инициализация тренера

trainer = Trainer(

model=model,

args=training_args,

data_collator=data_collator,

train_dataset=train_dataset,

)

# Запуск тренировки

trainer.train()Заключение

GPT представляет собой мощный инструмент для генерации текста и решения различных задач в области ИИ. В данной статье мы рассмотрели основные шаги для установки, настройки, загрузки модели, генерации текста, а также методы оптимизации и финетюнинга. Следуя представленным рекомендациям, вы сможете эффективно использовать GPT для своих проектов.